गले की फांस बनते डीपफेक वीडियो

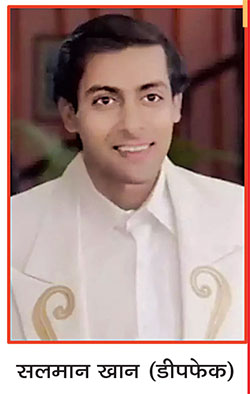

पहले दक्षिण भारतीय फिल्म अभिनेत्री रश्मिका मंदाना और उसके बाद बॉलीवुड अभिनेत्री कैटरीना कैफ तथा काजोल का डीपफेक वीडियो वायरल होने के बाद से डीपफेक मुद्दा लगातार चर्चा में है। हाल ही में शाहरूख खान और सलमान खान के डीपफेक वीडियो भी खूब वायरल हुए हैं, जिनमें उन्हें बेहद मोटा दर्शाया गया है। डीपफेक मुद्दे को लेकर आक्रोश तब और ज्यादा बढ़ गया था, जब फिल्म अभिनेत्रियों के डीपफेक वीडियो सामने आने के बाद प्रधानमंत्री नरेंद्र मोदी का भी एक ऐसा वीडियो वायरल हुआ, जिसमें उन्हें गरबा खेलते दिखाया गया जबकि स्वयं प्रधानमंत्री के मुताबिक उन्होंने कभी गरबा खेला ही नहीं। प्रधानमंत्री का ऐसा डीपफेक वीडियो वायरल होने के बाद यह एक बड़ा राष्ट्रीय मुद्दा बन गया। केन्द्रीय सूचना प्रौद्योगिकी मंत्री अश्विनी वैष्णव के मुताबिक सरकार जल्द ही डीपफेक मुद्दे पर मेटा और गूगल सहित सभी सोशल मीडिया मंचों से चर्चा करेगी और यदि इन मंचों ने इस संबंध में पर्याप्त कदम नहीं उठाए तो उन्हें आईटी अधिनियम के ‘सेफ हार्बर प्रतिरक्षा’ खंड के तहत संरक्षण नहीं मिलेगा। उनके मुताबिक कम्पनियों को ऐसी सामग्री पर कार्रवाई करने में अधिक आक्रामक होना होगा। दरअसल कृत्रिम मेधा यानी आर्टिफिशियल इंटेलीजेंस (एआई) की मदद से तैयार किए जा रहे डीपफेक वीडियो अब गले की फांस बनते जा रहे हैं और इसीलिए प्रधानमंत्री ने इसके खतरों को लेकर चेताते हुए कहा है कि एआई द्वारा बनाए गए डीपफेक बड़े संकट का कारण बन सकते हैं और समाज में असंतोष पैदा कर सकते हैं। इसीलिए उन्होंने मीडिया से इसके दुरुपयोग के बारे में जागरूकता बढ़ाने और लोगों को शिक्षित करने का आग्रह भी किया। राष्ट्रपति द्रौपदी मुर्मू ने भी अपराधियों द्वारा जेनरेटिव आर्टिफिशियल इंटेलीजेंस के इस्तेमाल तथा डीपफेक को लेकर चिंता जाहिर करते हुए कहा है कि पुलिस अधिकारियों को सदैव नई तकनीक से अपडेट रहना होगा ताकि अपराधियों पर बढ़त ली जा सके।

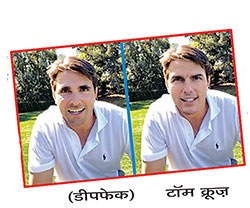

सबसे पहले यह जान लेना ज़रूरी है कि डीपफेक आखिर है क्या? डीपफेक शब्द वास्तव में ‘डीप लर्निंग’ और ‘फेक’ के मेल से बना है। किसी भी वीडियो में किसी व्यक्ति के चेहरे अथवा शरीर को डिजिटल रूप से बदलने को ‘डीपफेक’ कहते हैं। डीपफेक वीडियो और ऑडियो दोनों ही रूप में हो सकता है। इसे एक स्पेशल मशीन लर्निंग का इस्तेमाल करके बनाया जाता है, जिसे ‘डीप लर्निंग’ कहा जाता है। डीप लर्निंग में कम्प्यूटर को दो वीडियो या फोटो दिए जाते हैं, जिन्हें देखकर वह स्वयं ही दोनों वीडियो या फोटो को एक जैसा बनाता है यानी एडिटेड वीडियो में किसी अन्य के चेहरे को किसी अन्य के चेहरे से बदल दिया जाता है। इस तरह के फोटो तथा वीडियो में कुछ छिपी हुई लेयर्स होती हैं, जिन्हें केवल एडिटिंग सॉफ्टवेयर की मदद से ही देखा जा सकता है। ये वीडियो इतने सटीक होते हैं कि आप इन्हें आसानी से नहीं पहचान सकते। यही कारण है कि डीपफेक फोटो और वीडियो फेक होते हुए भी असली नज़र आते हैं। एआई की मदद से बने ऐसे वीडियो किसी को भी आसानी से धोखा देने में पूरी तरह सक्षम होते हैं। डीपफेक में कृत्रिम मेधा और आधुनिक तकनीकों का इस्तेमाल करते हुए किसी वीडियो क्लिप अथवा फोटो पर किसी अन्य व्यक्ति का चेहरा लगाने का चलन तेज़ी से बड़ रहा है। इसके जरिये कृत्रिम तरीके से ऐसे क्लिप या फोटो विकसित किए जा रहे हैं, जो देखने में वास्तविक लगते हैं। डीपफेक के लिए इन दिनों कई वेबसाइट और एप हैं, जहां लोग ऐसे वीडियो बना रहे हैं।

डीपफेक कंटेंट एक-दूसरे के साथ प्रतिस्पर्धा करते दो एल्गोरिदम (डिकोडर और एनकोडर) का उपयोग करके तैयार किए जाते हैं। इस बेहद पेचीदा तकनीक में फेक डिजिटल कंटेंट बनाकर डिकोडर के जरिये यह पता लगाया जाता है कि कंटेंट असली है या नकली। डिकोडर हर बार कंटेंट को असली अथवा नकली के रूप में सही ढंग से पहचानता है और फिर उस जानकारी को एनकोडर को भेज देता है ताकि अगले डीपफेक में गलतियां सुधारकर उसे और बेहतर किया जा सके। उसके बाद जो फाइनल आउटपुट निकलता है, वह बिल्कुल असली जैसा होता है लेकिन वास्तव में वह फेक होता है। यह तकनीक जनरेटिव एडवर्सरियल नेटवर्क (जीएएन) का इस्तेमाल करती है, जिससे फेक वीडियो और फोटो बनाए जाते हैं। सोशल मीडिया प्लेटफॉर्म पर डीपफेक वीडियो डाले जाने के बाद ये बहुत तेज़ गति से फैलते हैं। विभिन्न रिपोर्टों के मुताबिक इंटरनेट पर इस समय करोड़ों डीपफेक वीडियो मौजूद हैं। हालांकि इस तकनीक का इस्तेमाल मनोरंजन के लिए भी किया जाता है लेकिन पोर्नोग्राफी में इस तकनीक का काफी इस्तेमाल होता है। डीपफेक के जरिये ही किसी फिल्म अभिनेता अथवा अभिनेत्री का चेहरा बदलकर पोर्न साइटों पर अश्लील कंटेंट पोस्ट किया जाता है। माना जाता है कि इस तकनीक की शुरुआत ही अश्लील कंटेंट बनाने से हुई थी। ‘डीपट्रेस’ की एक रिपोर्ट के मुताबिक 2019 में ऑनलाइन पाए गए डीपफेक वीडियो में करीब 96 प्रतिशत अश्लील कंटेंट ही था।

डीपफेक मुद्दे पर चिंता बढ़ने का सबसे बड़ा कारण यही है कि क्योंकि इसमें दिखने वाला वीडियो बिल्कुल सही होता है किन्तु एआई के जरिये चेहरा, वातावरण अथवा असली ऑडियो बदल दिया जाता है और देखने वाले को इस बात का जरा भी अहसास नहीं होता कि वह असली नहीं बल्कि डीपफेक वीडियो देख रहा है। भारत में डीपफेक मुद्दे पर आक्रोश पहली बार तब उभरा था, जब डीपफेक तकनीक के जरिये तैयार किया गया एक ऐसा वीडियो वायरल हुआ था, जिसमें नज़र आ रही एक महिला को ‘पुष्पा’ जैसी सफल फिल्म से प्रसिद्ध हुई अभिनेत्री रश्मिका मंदाना की तरह दिखाने का प्रयास किया गया था। तब अमिताभ बच्चन ने इस वीडियो का संदर्भ देते हुए सोशल मीडिया प्लेटफॉर्म पर लिखा था कि इस मामले में कानूनी कार्रवाई होनी चाहिए। इलैक्ट्रॉनिक्स और आईटी राज्यमंत्री राजीव चंद्रशेखर के मुताबिक डीपफेक एक बड़ा उल्लंघन है और यह विशेष रूप से महिलाओं को नुकसान पहुंचाता है।

डीपफेक तकनीक का इतिहास देखें तो पहली बार 2014 में इयन गुडफ्लो और उनकी टीम ने इस तकनीक को विकसित किया था, जिसमें धीरे-धीरे नई-नई तकनीकों के साथ नए-नए परिवर्तन किए जाते रहे। वैसे 1997 में भी क्रिस्टोफ ब्रेगलर, मिशेल कोवेल और मैल्कम स्लेनी ने भी डीपफेक तकनीक की मदद से एक वीडियो में विजुअल से छेड़छाड़ की थी और एंकर द्वारा बोले जा रहे शब्दों को बदल दिया था लेकिन उसे एक प्रयोग के तौर पर किया गया था। हालांकि इस तकनीक का इस्तेमाल हॉलीवुड फिल्मों में बड़े पैमाने पर किया जाता रहा है। दरअसल शूटिंग के दौरान कई बार किसी कलाकार के पास डेट्स की कमी होने या शूटिंग के बीच में ही किसी कलाकार की मौत हो जाने पर इस तकनीक का इस्तेमाल किया जाता था लेकिन तब इस तकनीक का इस्तेमाल नकारात्मक तरीके से नहीं होता था लेकिन जैसे-जैसे यह तकनीक परिष्कृत होती गई, असली-नकली का फर्क करना भी मुश्किल होने लगा और कुछ लोग इसका गलत इस्तेमाल करने लगे। इसी परिष्कृत तकनीक के जरिये विभिन्न हॉलीवुड और बॉलीवुड अभिनेत्रियों के पोर्न वीडियो बनाए जाने लगे। अनेक पोर्न वेबसाइट ऐसे डीपफेक वीडियो से भरी पड़ी हैं। पहली बार डीपफेक शब्द 2017 के अंत में एक ‘रेडिट’ उपयोगकर्ता द्वारा बनाया गया था, जिसने अश्लील वीडियो पर विख्यात हस्तियों के चेहरे को सुपरइम्पोज करने के लिए डीप लर्निंग तकनीक का इस्तेमाल किया था। 2018 तक ओपन-सोर्स लाइब्रेरी तथा ऑनलाइन शेयर किए गए ट्यूटोरियल की बदौलत यह तकनीक इस्तेमाल में आसान हो गई और 2020 के दशक में तो डीपफेक और ज्यादा परिष्त हो गए, जिनका पता लगाना कठिन हो गया।

हालांकि डीपफेक तकनीक से तैयार तस्वीरों और वीडियो को पहचानना आसान तो नहीं होता लेकिन यह असंभव भी नहीं है। विशेषज्ञों का कहना है कि हालांकि डीपफेक वीडियो को पकड़ना आसान हो सकता है क्योंकि ये इंटरनेट पर मौजूद असली वीडियो से ही बनाए जा सकते हैं लेकिन भारत में ऐसे वीडियो को लेकर चिंता की सबसे बड़ी बात यही है कि हमारे यहां इसके लिए जिस धैर्य की ज़रुरत है, वह व्हाट्सएप संदेश अग्रेषित करते रहने वाले लोगों में नहीं दिखती। दरअसल लोग बिना कुछ सोचे-समझे किसी भी संदेश को एक-दूसरे को अग्रेषित करते रहते हैं। एसी नेल्सन की ‘इंडिया इंटरनेट रिपोर्ट 2023’ के आंकड़ों के मुताबिक ग्रामीण भारत में 42.5 करोड़ से अधिक इंटरनेट उपयोगकर्ता हैं, जो शहरी भारत की तुलना में 44 प्रतिशत अधिक हैं और इनमें से 29.5 करोड़ लोग नियमित रूप से इंटरनेट का उपयोग करते हैं, ऐसे में डीपफेक वीडियो को लेकर जागरूकता के अभाव में इसके भावी खतरों को समझना कठिन नहीं है। देश में डिजिटल साक्षरता कम होने के कारण ऐसे वीडियो समस्या को बेहद गंभीर बना सकते हैं। दरअसल एक ओर जहां एआई के आगमन से आर्थिक और सामाजिक विकास को लेकर उम्मीदें बड़ी थी, साथ ही यह भी माना जा रहा था कि एआई के जरिये फेक न्यूज और गलत सूचनाओं के प्रसार को रोकने का प्रभावी तरीका मिल जाएगा लेकिन एआई का उपयोग बढ़ने के साथ-साथ इसका दुरूपयोग तेजी से बढ़ रहा है, जिससे न सिर्फ फेक न्यूज में वृद्धि हो रही है बल्कि इंटरनेट अब चरित्र हनन करने के मामले में भी एक शक्तिशाली औजार के रूप में उभर रहा है।

मो-9416740584